ESP8266

接口

动态规划

测试用例

opencv

xss

MCAL

html网页模版

turtle

论文选题

控制算法

web大学生网页作业成品

nexus

实时音视频

OData

GPT-4

skill 命令

高校失物招领系统

语义分割

ATM系统

注意力

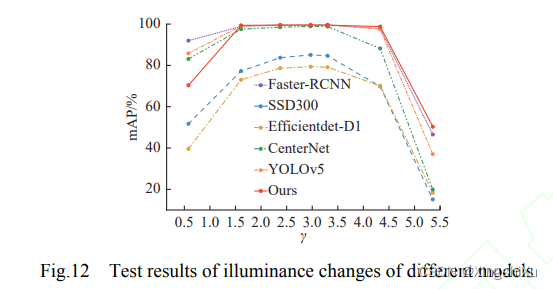

2024/4/11 21:26:10【YOLOv 剪枝 轻量化】融合YOLOv5s与通道剪枝算法的奶牛轻量化个体识别方法(英文版含中文翻译)

融合YOLOv5s与通道剪枝算法的奶牛轻量化个体识别方法 Light-weight recognition network for dairy cows based on the fusion of YOLOv5s and channel pruning algorithm

论文链接 知网链接 DOI链接 引用格式: 许兴时,王云飞,华志新&#x…

注意力机制 Attention模型 global attention 和 local attention

Attention model 可以应用在图像领域也可以应用在自然语言识别领域

本文讨论的Attention模型是应用在自然语言领域的Attention模型,本文以神经网络机器翻译为研究点讨论注意力机制,参考文献《Effective Approaches to Attention-based Neural Machine T…

如何训练大脑提升专注力

这里填写标题1. 如何训练大脑提升专注力1.1. 参考:1. 如何训练大脑提升专注力

一次专注做一件事避免或降低暗示 (把手机放到够不到的地方)每天练习冥想 (从 3 分钟开始, 慢慢到 10 分钟)

1.1. 参考:

【对抗诱惑!】如何训练大脑提升专注力!

NLP学习笔记(五) 注意力机制

大家好,我是半虹,这篇文章来讲注意力机制 (Attention Mechanism) 在序列到序列模型中的应用 在上一篇文章中,我们介绍了序列到序列模型,其工作流程可以概括为以下两个步骤

首先,用编码器将输入序列编码成上下文向量&a…

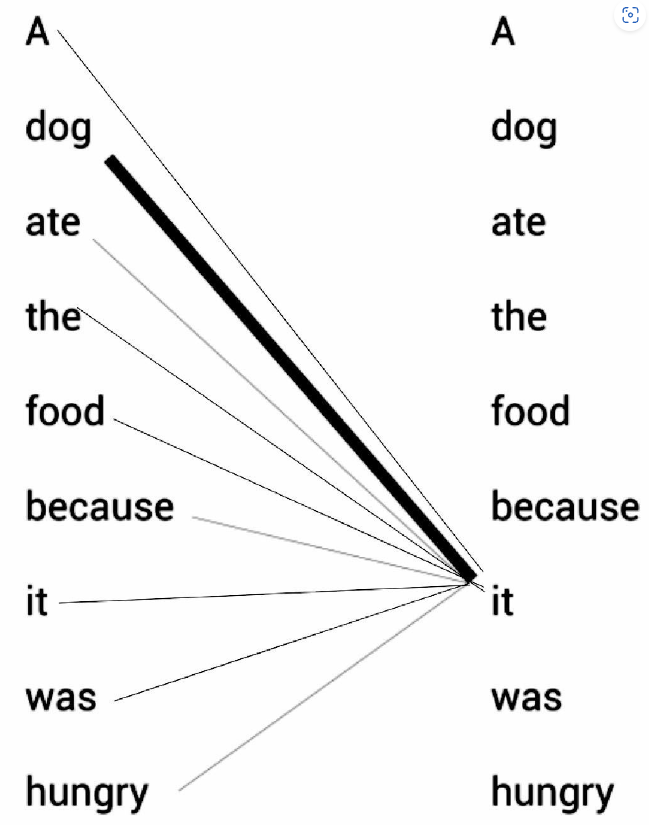

机器学习笔记 - 通过一个例子来快速理解自注意力机制/缩放点积注意力机制

一、一个简单的示例 请看下面的例句:A dog ate the food because it was hungry(一只狗吃了食物,因为它很饿) 例句中的代词it(它)可以指代dog(狗)或者food(食物)。当读这段文字的时候,我们自然而然地认为it指代的是dog,而不是food。但是当计算机模型在面对这两种选…

关系抽取之远程监督方法总结

目录前言1. 远程监督关系抽取开山之作1.1 介绍1.2 训练过程1.2.1 数据标注方法1.2.2 训练方法1.3 测试过程1.4 思考1.5 总结2. PCNN2.1 介绍2.2 模型结构2.3 实验结果3. 句子级别注意力3.1介绍3.2 模型结构3.2.1 句子编码器3.2.2 注意力层3.3 实验结果前言 本文总结关系抽取中的…

《论文阅读》任务型对话系统——面向角色的对话摘要

《论文阅读》任务型对话系统——面向角色的对话摘要 前言文本摘要对话摘要Other Roles Matter! Enhancing Role-Oriented Dialogue Summarization via Role Interactions角色信息的作用角色对话摘要的定义解决方法两种交互模型构架启发前言

分享的一篇论文为: Other Roles Ma…

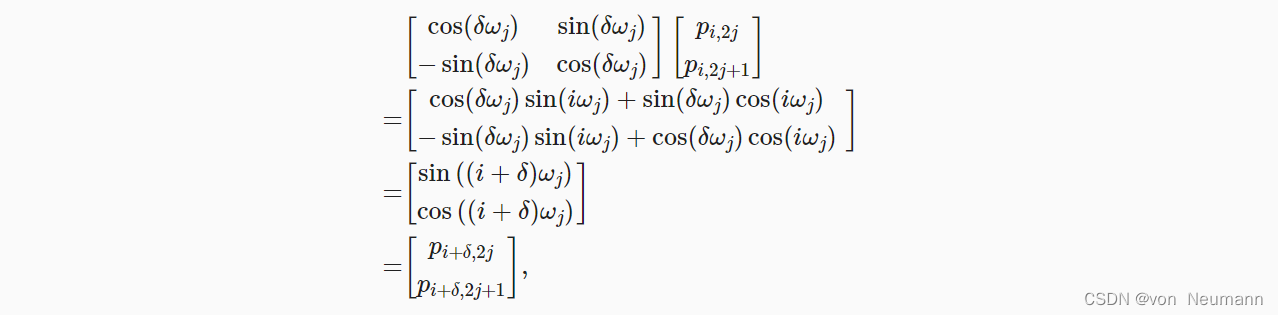

深入理解深度学习——注意力机制(Attention Mechanism):位置编码(Positional Encoding)

分类目录:《深入理解深度学习》总目录

相关文章: 注意力机制(AttentionMechanism):基础知识 注意力机制(AttentionMechanism):注意力汇聚与Nadaraya-Watson核回归 注意力机制&#…

学习记录——BiFormer

BiFormer Vision Transformer with Bi-Level Routing Attention

BiFormer:具有双电平路由注意的视觉变压器 摘要作为视觉转换器的核心组成部分,注意力是捕捉长期依赖关系的有力工具。然而,这样的能力是有代价的:当计算跨所有空间位置的成对令牌交互时,它会产生巨大的计算负…

“注我“ - 从社交软件夺回人们自己的注意力

你太在意什么事情,就会被其奴役。 先上牌桌,再谈命运。

不可能三角:

效率 其乐

Keywords: workflow, self-attention, high-efficiency, focus.

AI里面的Transformer得益于attention有不错的效果,本质是对应该注意的东西的…